Sisältö

- Big Data on jäsentämätöntä tai puolittain rakennettua

- Ei ole mitään syytä tallentaa suuria tietoja, jos emme pysty käsittelemään sitä

- Kuinka Hadoop ratkaisee suurten tietojen ongelman

- Hadoopin liiketoimintatapa

Ottaa mukaan:

Hadoop voi auttaa ratkaisemaan joitain suurista dat isoista haasteista.

Big data on ... no ... iso koko! Sitä, kuinka paljon tietoa voidaan luokitella isoksi tiedoksi, ei ole kovin selkeä, joten älä pidä juurttua keskusteluun. Pienelle yritykselle, joka on tottunut käsittelemään dataa gigatavuina, 10 TB dataa olisi BIG. Kuitenkin yrityksille, kuten ja Yahoo, petabyytit ovat suuret.Pelkästään suuren datan koko tekee mahdottomaksi (tai ainakin kustannuksia estävän) tallentamisen perinteiseen tallennustilaan, kuten tietokantoihin tai tavanomaisiin tiedostoihin. Puhumme gigatavujen tietojen tallennuskustannuksista. Perinteisten tallennusrekisterien käyttäminen voi maksaa paljon rahaa suurten tietojen tallentamiseen.

Täällä on hyvä katsoa iso data, sen haasteet ja kuinka Hadoop voi auttaa niiden ratkaisemisessa.Ensin, suuret datasuuri haasteet.

Big Data on jäsentämätöntä tai puolittain rakennettua

Paljon suurta dataa on jäsentämätöntä. Esimerkiksi napsauttamalla stream-lokitiedot saattavat näyttää seuraavalta:aikaleima, käyttäjätunnus, sivu, viittaussivu

Rakenteen puute tekee relaatiotietokannoista, jotka eivät ole sopivia suurten tietojen tallentamiseen. Lisäksi monet tietokannat eivät selviä miljardeja rivejä tietoja.

Ei ole mitään syytä tallentaa suuria tietoja, jos emme pysty käsittelemään sitä

Suurien tietojen tallentaminen on osa peliä. Meidän on käsiteltävä se tiedustelupalvelun saamiseksi siitä. Perinteiset tallennusjärjestelmät ovat melko "tyhmiä" siinä mielessä, että ne vain tallentavat bittejä. He eivät tarjoa mitään prosessointitehoa.Perinteisessä tietojenkäsittelymallissa on tietoja, jotka on tallennettu tallennus klusteriin, joka kopioidaan laskentoklusteriin käsittelyä varten. Tulokset kirjoitetaan takaisin tallennus klusteriin.

Tämä malli ei kuitenkaan aivan toimi isojen tietojen kanssa, koska niin suuren tiedon kopioiminen laskentaklusteriin voi olla liian aikaa vievää tai mahdotonta. Joten mikä on vastaus?

Yksi ratkaisu on prosessoida iso data paikallaan, kuten varastointi klusterissa, joka kaksinkertaistuu laskennallisena klusterina.

Joten kuten edellä olemme nähneet, iso data uhmaa perinteistä tallennusta. Joten miten käsittelemme suuria tietoja?

Kuinka Hadoop ratkaisee suurten tietojen ongelman

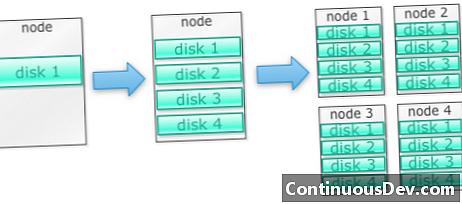

Hadoop on rakennettu toimimaan klusterikoneissaAloitetaan esimerkillä. Sanotaan, että meidän on tallennettava paljon kuvia. Aloitamme yhdellä levyllä. Kun ylitämme yhden levyn, saatamme käyttää muutamia koneessa pinottuja levyjä. Kun maksimoimme kaikki levyt yhdellä koneella, meidän on saatava joukko koneita, joissa jokaisessa on joukko levyjä.

Näin Hadoop on rakennettu. Hadoop on suunniteltu toimimaan koneiden klusterissa alusta alkaen.

Hadoop-klusterit skaalautuvat vaakatasossa

Lisää tallennus- ja laskentatehoa voidaan saavuttaa lisäämällä lisää solmuja Hadoop-klusteriin. Tämä poistaa tarpeen ostaa enemmän ja tehokkaampia ja kalliimpia laitteita.

Hadoop pystyy käsittelemään jäsentämätöntä / osittain jäsentämätöntä tietoa

Hadoop ei pane järjestelmää täytäntöön tallentamissaan tiedoissa. Se voi käsitellä mielivaltaisia ja binaaritietoja. Joten Hadoop voi sulauttaa kaiken rakenteettoman tiedon helposti.

Hadoop-klusterit tarjoavat tallennusta ja laskentaa

Näimme, kuinka erilliset tallennus- ja käsittely klusterit eivät ole parhaiten sopivia suurille tiedoille. Hadoop-klusterit tarjoavat kuitenkin tallennustilan ja hajautetun laskennan yhdessä.

Hadoopin liiketoimintatapa

Hadoop tarjoaa isojen tietojen tallennuksen kohtuulliseen hintaan

Suurten tietojen tallentaminen perinteistä tallennusta käyttämällä voi olla kallista. Hadoop on rakennettu hyödykelaitteiden ympärille, joten se voi tarjota melko suuren tallennustilan kohtuulliseen hintaan. Hadoop-kenttää on käytetty kentällä petabyytin mittakaavassa.

Yksi Clouderan tekemä tutkimus ehdotti, että yritykset käyttävät yleensä noin 25 000–50 000 dollaria teratavua kohti vuodessa. Hadoopin kanssa tämä hinta putoaa muutamaan tuhanteen dollariin teratavulta vuodessa. Koska laitteistot halvempaa, kustannukset laskevat edelleen.

Hadoop sallii uuden tai useamman datan sieppauksen

Joskus organisaatiot eivät sieppa tietyn tyyppisiä tietoja, koska niiden tallentaminen oli liian kustannuksellista. Koska Hadoop tarjoaa tallennuksen kohtuulliseen hintaan, tämäntyyppiset tiedot voidaan siepata ja tallentaa.

Yksi esimerkki olisi verkkosivustojen napsautuslokit. Koska näiden lokien määrä voi olla erittäin suuri, harvat organisaatiot eivät kiinni niitä. Nyt Hadoopilla on mahdollista tallentaa ja tallentaa lokit.

Hadoopin avulla voit tallentaa tietoja pidempään

Tallennetun tiedon määrän hallitsemiseksi yritykset puhdistavat säännöllisesti vanhemmat tiedot. Esimerkiksi vain viimeisen kolmen kuukauden lokit voitiin tallentaa, kun taas vanhemmat lokit poistettiin. Hadoopilla on mahdollista tallentaa historiallista tietoa pidempään. Tämä sallii uuden analyysin tekemisen vanhemmille historiallisille tiedoille.

Ota esimerkiksi napsautuslokeja verkkosivustolta. Muutama vuosi sitten nämä lokit tallennettiin lyhyeksi ajaksi tilastojen, kuten suosittujen sivujen, laskemiseksi. Nyt Hadoopin kanssa on kannattavaa tallentaa näitä napsautuslokeja pidempään aikaan.

Hadoop tarjoaa skaalattavaa analytiikkaa

Kaikkia näitä tietoja ei tarvitse tallentaa, jos emme pysty niitä analysoimaan. Hadoop ei vain tarjoa hajautettua tallennusta, vaan myös hajautettua prosessointia, mikä tarkoittaa, että pystymme puristamaan suuren määrän dataa samanaikaisesti. Hadoopin laskennallinen kehys on nimeltään MapReduce. MapReduce on todistettu petatavujen mittakaavassa.

Hadoop tarjoaa runsaasti analytiikkaa

Native MapReduce tukee Javaa ensisijaisena ohjelmointikielenä. Muita kieliä, kuten Ruby, Python ja R, voidaan myös käyttää.

Mukautetun MapReduce-koodin kirjoittaminen ei tietenkään ole ainoa tapa analysoida tietoja Hadoopissa. Korkeamman tason karttaa voidaan käyttää. Esimerkiksi Pig-niminen työkalu vie englantia kuten tiedonsiirtokieli ja kääntää ne MapReduce-muotoon. Toinen työkalu, Hive, ottaa SQL-kyselyitä ja suorittaa ne MapReduce-sovelluksella.

Business Intelligence (BI) -työkalut voivat tarjota entistä korkeamman tason analyysejä. Tämän tyyppiseen analyysiin on olemassa työkaluja.

Tämä sisältö on katkelma Mark Kerznerin ja Sujee Maniyamin julkaisusta "Hadoop Illuminated". Se on asetettu saataville Creative Commons Attribution-NonCommercial-ShareAlike 3.0 Unported -lisenssillä.